ใครอยากพัฒนาตัวเองให้ไวเหมือน AI (ลองมาเข้าใจวิธีที่ AI มันพัฒนาตัวเองก่อน)

.

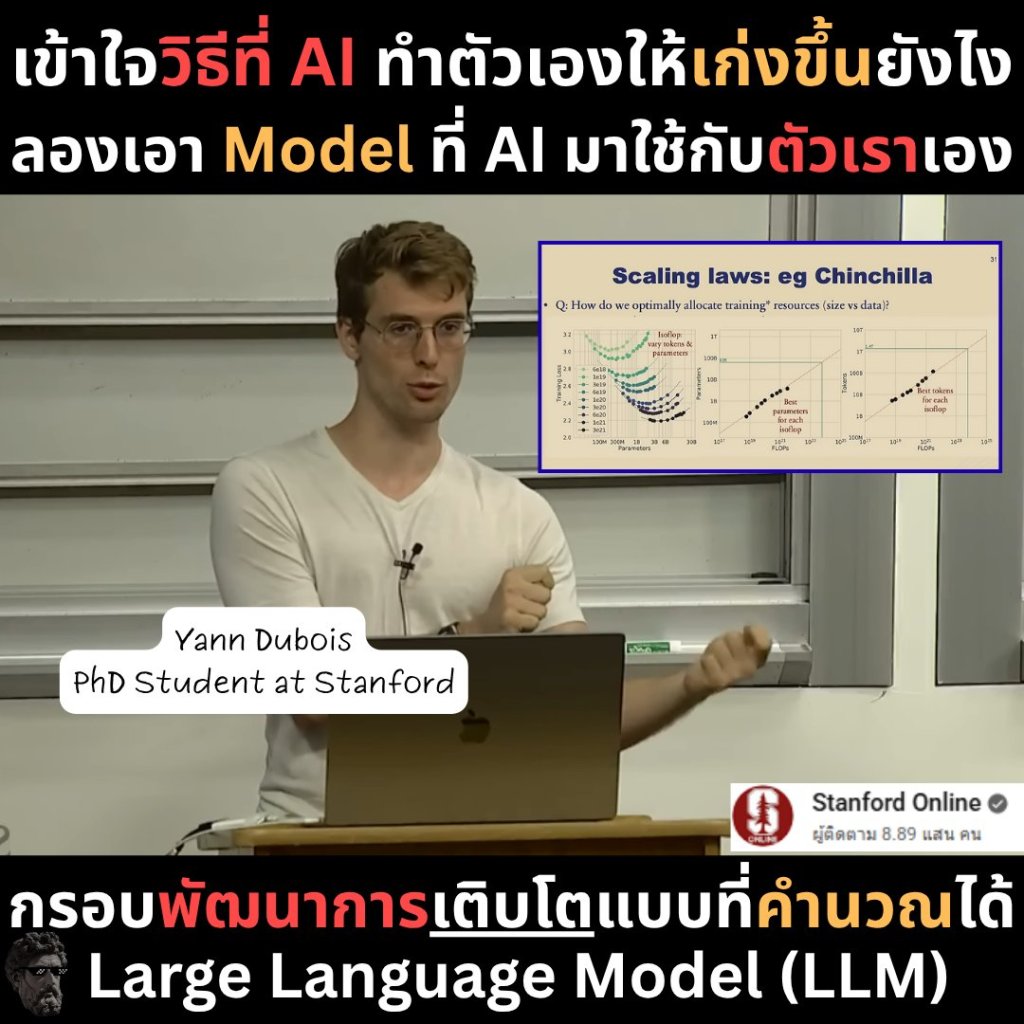

เมื่อคืนผมนั่งดู Lecture ของ Stanford CS229: Building Large Language Models สอนโดย Yann Dubois PhD Student ของที่ Stanford

.

เขาอธิบายให้เข้าใจแบบง่าย ๆ ว่า LLM (Large Language Model) ทำงานยังไง หรือพูดอีกแบบคือ “สมองของ AI มันเรียนรู้จากอะไร”

.

แล้วเราจะเอามาปรับใช้กับเรายังไงในมุมให้เราเก่งขึ้น

#อ่านจบปุ๊ปเก่งขึ้นปั๊ป

—————————–

Part 1 : Language Model สมองของ AI ที่เกิดจาก “การเดา”

Yann Dubois เริ่มจากพื้นฐานที่เรียกว่า Language Modeling

แนวคิดที่ว่า “AI เรียนรู้จากการคาดเดาคำถัดไป”

.

ทุกครั้งที่มันเห็นประโยคหนึ่ง ๆ

มันจะพยายาม ทำนายคำถัดไป จากคำก่อนหน้า

เช่น “ฉันเดินเข้าไปใน…”

AI จะต้องเดาว่า “ห้อง” หรือ “ป่า” หรือ “ห้าง” อันไหนน่าจะมาต่อ

นั่นคือสิ่งที่มันฝึกอยู่ทุกวัน “การเดา” ให้แม่นขึ้นเรื่อย ๆ

/////#ช่วงขอNerd แปปเดียวอันนี้ ข้ามได้ๆ ///////

ในทางคณิตศาสตร์ มันมาจากสิ่งที่เรียกว่า

Chain Rule of Probability

หรือสูตรที่คำนวณว่า “คำต่อไปมีโอกาสเกิดขึ้นแค่ไหน” จากคำก่อนหน้า

.

และทุกครั้งที่มันเดาผิด มันจะ “อัปเดต Weight ในสมอง” ทันที

เพื่อให้ครั้งหน้ามันเดาได้ดีขึ้น

.

เรามีชื่อเรียกกระบวนการนี้ว่า Cross-Entropy Loss

มันคือค่าที่วัดว่า “สิ่งที่เดา” กับ “สิ่งที่จริง” ต่างกันมากแค่ไหน

ถ้า Loss ต่ำ = เดาแม่น = เข้าใจภาษาได้ดี

ถ้า Loss สูง = เดาพลาด = ต้องฝึกใหม่

//////////Nerd จบ /////////////

AI ไม่ได้เรียนรู้จากการถูก

แต่มันเติบโตจากการผิดพลาด

และนี่คือจุดที่ “มันจะเก่งกว่าคนเฉพาะเรื่องได้”

เพราะมันไม่เหนื่อยจากการผิด ไม่อีโก้ ไม่กลัวลอง และมันทำแบบนี้ไม่หยุด

—————————-

Part 2 – ส่วนประกอบหลักของสมอง AI (LLM)

พอเข้าใจกลไก “การเดา” แล้ว Yann Dubois ก็สรุปสิ่งที่ทำให้ AI โตไวไว้ 5 ส่วน

[1] Architecture – โครงสร้างสมองที่เข้าใจบริบทได้ผ่าน Self-Attention

สร้างกรอบให้เห็นทั้งประโยคพร้อมกันแบบคนจริง ๆ ไม่ใช่อ่านทีละคำ

เพราะ “บริบท” คือหัวใจของความเข้าใจ ไม่ใช่คำแยกกัน

[2] Training Loss – กลไกการเรียนรู้จากความผิดพลาด

AI วัดความต่างระหว่าง “คำที่เดา” กับ “คำจริง” ผ่าน Cross-Entropy Loss (ที่เล่าไปใน Part 1) แล้ว ปรับจูนทุกครั้งที่ผิดพลาด เพื่อเดาแม่นขึ้นทุกครั้ง

[3] Data – อาหารสมองของ AI

มันเรียนรู้จากข้อมูลมหาศาล เช่น หนังสือ โค้ด และ Wikipedia แต่ถ้าข้อมูลเน่า สมองก็เน่า

Garbage In = Garbage Out

[4] Evaluation – การสอบวัดผลด้วยค่า Perplexity

ยิ่งค่าต่ำ แปลว่ามันเข้าใจภาษาได้ลึกและเดาแม่นขึ้น

เหมือนคนที่เข้าใจหลักการ ไม่ใช่แค่ท่องจำ

[5] Systems – กล้ามเนื้อและพลังงานของ AI

ใช้ GPU และ Distributed Training ฝึกพร้อมกันหลายพันเครื่อง ทำให้โตไว แข็งแรง และเรียนรู้ได้ต่อเนื่อง

ถ้าฟังแบบนี้เราจะเข้าใจมากขึ้นว่า AI โตไว เพราะมันมีระบบพัฒนาที่ดี

มันเดา → พลาด → แก้ → ทดสอบ → อัปเดต → เดาต่อไป

—————————-

Part 3 Scaling Law: กฎแห่งการเติบโตของ AI

Yann Dubois เขาเลยก็พูดถึงแนวคิดต่อมาที่ทรงพลังมากที่สุดในวงการ Deep Learning คือ Scaling Law หรือ “กฎแห่งการโตแบบคาดการณ์ได้”

.

กฎนี้พูดง่าย ๆ คือ

AI จะโตขึ้น ทุกครั้งที่เราขยายมันอย่างถูกจุด

ไม่ว่าจะ [1] เพิ่มจำนวนเซลล์สมอง (Parameters)

[2] เพิ่มประสบการณ์ชีวิต (Data)

[3] หรือเพิ่มพลังในการคิด (Compute)

ถ้าเราเพิ่ม [สมองให้ฉลาดขึ้น], [ข้อมูลให้มากขึ้น] และ [พลังประมวลผลให้แรงขึ้น] โมเดลจะฉลาดขึ้นเรื่อย ๆ แบบแทบจะทำนายได้ล่วงหน้าเลยว่ามันจะเก่งขึ้นเท่าไหร่ (แบบควบคุมความเก่งแบบมีทิศทางเก็จไหม)

.

จากงานวิจัยอย่าง Scaling Laws ของ OpenAI และ Chinchilla ของ DeepMind บอกว่า

.

“ไม่ใช่แค่ใหญ่ขึ้นถึงจะฉลาดขึ้น”

.

แต่ว่าต้องขยายทั้ง 3 ด้าน แบบ Balance กัน

ขนาดที่รับข้อมูล (Parameters) ,ข้อมูล (Data) ,พลังคิด (Compute)

.

เราต้องการข้อมูลที่ดีไม่ใช่ ขยะเข้าไป

ซึ่งตอนนี้ เขายังไม่เจอจุด จุดอิ่มตัวให้เห็นในตอนนี้เลย

นั่นคือเหตุผลที่บริษัทยักษ์ใหญ่ทั่วโลก

ยังคง “เทเงิน” ลงในการสร้างโมเดลใหญ่ขึ้นเรื่อย ๆ

———————

Part 4 – Scaling Law for Human Growth

ตอนผมนั่งฟังคลิปนี้ก็เลยเอามาลองปรับ Frame ให้เข้ากับมนุษย์เราดู

.

AI เติบโตได้เพราะมันไม่ใช่แค่ “ฉลาด” ถ้าดูปัจจัยความเก่งของมัน

มนุษย์เองก็ทำได้ ถ้าเราสร้าง Scaling Framework ของตัวเองให้ถูกจุด

[1] Parameters → Skill Connection

ยิ่งเราต่อทักษะได้มาก สมองยิ่งเชื่อมโยงเก่ง

อย่าเรียนแค่เส้นเดียว – ต่อ Skill แบบ Design + Marketing, Writing + Psychology

[2] Data → Information Diet

สิ่งที่เราอ่าน ดู ฟัง คือ Data Set ของสมอง

Garbage In = Garbage Out

เลือกกิน “ข้อมูลดี” แล้วสมองจะเทรนตัวเอง

(เช่น มาอ่านเพจนี้ทุกวัน แฮร่)

[3] Compute → Focus Power

สมาธิคือพลังประมวลผลของคน

Deep Focus = สมองเข้าใจเร็วกว่าใคร (เล่น Short น้อยๆหน่อย5555)

[4] Loss → Learn from Error

AI โตจากการผิด คนก็เหมือนกัน

ผิด = ข้อมูลใหม่, ล้ม = จุดรีเซ็ตใหม่ (ยอมรับความผิดพลาดของตัวเอง)

[5] System → Training Loop

ระบบที่ดี = จะเติบโตได้แม้ไม่มีแรงบันดาลใจ

ฝึกซ้ำทุกวัน สะสมเล็ก ๆ ให้กลายเป็น Compound Growth

ลองออกแบบ Frame การเรียนรู้ของเรา

—————————–

ถ้าคุณชอบบทความแนวนี้ แล้วไม่อยากพลาด สามารถใส่ Email ของคุณได้ที่ Link นี้เลย (ฟรีไม่มีค่าใช้จ่าย)

#สรุปแบบลงดาบ

AI ไม่ได้เก่งเพราะมันฉลาดกว่าเรา

แต่มัน “มีระบบพัฒนาที่ดีกว่าเรา” ที่ไม่หยุดนิ่ง

.

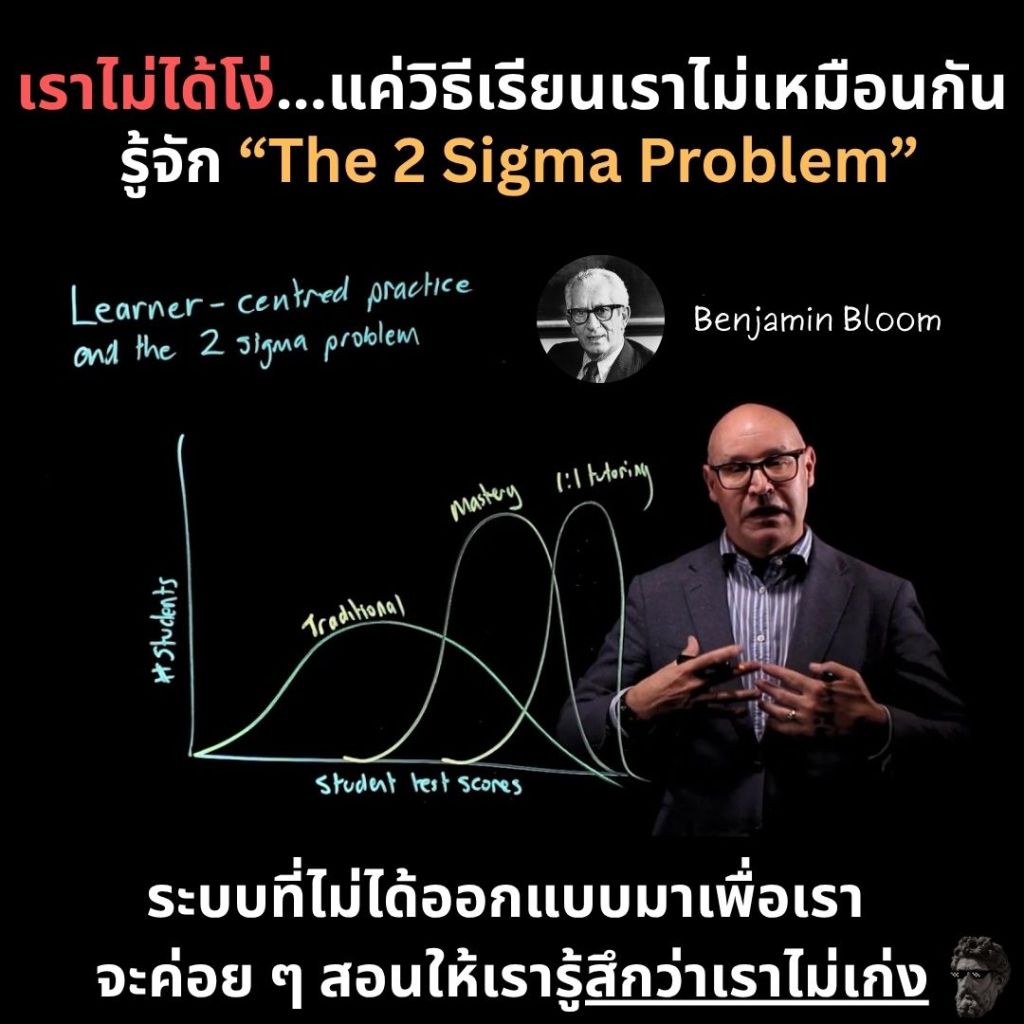

เราเรียนแบบสุ่ม แต่ AI เรียนแบบมีโครงสร้าง

.

มันเดา → พลาด → แก้ → สอบ → อัปเดต → เดาต่อ

ในขณะที่เราพลาด → ท้อ → หยุด บ่น เซง 5555

.

ถ้าเราเริ่มคิดแบบ AI

เข้าใจตัวเองเป็น “ระบบที่ฝึกได้” ไม่ใช่ “คนที่เก่งหรือไม่เก่ง”

เราก็จะเติบโตได้เร็วแบบคาดการณ์ได้เหมือนกัน

.

ผมหวังว่าเรื่องนี้จะช่วยสร้างวันของคุณ

ใส่ความเห็น